Ce site n'est plus le bon car, suite au rachat de chez.com par Tiscali qui,

apparemment ne fait plus correctement la maintenance, il ne peut peut plus

être mis à jour.

Rendez-vous sur mon nouveau site : http://membres.lycos.fr/flesia/tdt/prospect.htm

|

LES INNOVATIONS DE RUPTURE ou LES TECHNOLOGIES AVANCÉES ET LE FUTUR |

Par Elio FLESIA

e-mail : eflesia![]() up.univ-mrs.fr

up.univ-mrs.fr

Faites connaissance avec

l'auteur : http://www.chez.com/flesia/perso.html

|

Ce texte constitue l’un des chapitres d'un cours de DEA sur le transfert de technologie et l'innovation dont je suis chargé à l'université Aix-Marseille 3 depuis plusieurs années. A la demande de certains de mes étudiants, j’ai décidé (avril 2002) de rendre l’ensemble de ce cours (une centaine de pages) téléchargeable au format PDF (et ceci malgré son caractère de document de travail non définitif et le fait que les chiffres et autres données numériques que cette version contient soient déjà un peu anciens et mériteraient d’être réactualisés). Pour le télécharger, cliquer ici. |

1. L'illusion de la fin de

la science

2. La méfiance envers le

progrès technique

3.

Le conformisme

dans la recherche

4.

Le conformisme

n'empêche pas les erreurs

5. Comment les idées neuves

finissent par s'imposer

6. L'importance du facteur

temps

7. Intelligence de la

méthode ou méthode de l'intelligence ?

8. Le "cas"

français

9. Scénarios pour le

futur

10. Quelle place pour l'Homme

?

En ce début de millénaire, nombreux sont ceux, penseurs ou simples citoyens, qui en observant ce qui se passe autour d'eux, en viennent à se poser de nombreuses questions. Les plus pessimistes vont même jusqu'à s'interroger sur le bien-fondé du progrès technique et, même si ceci est inconscient chez eux, ils donnent parfois l'impression de désirer un arrêt du processus ou du moins un moratoire. Or, une partie du progrès technique est de plus en plus tributaire des découvertes réalisées dans les laboratoires de recherche et si l'on n'y prête garde les "savants" pourraient fort bien, dans un avenir pas très lointain, être désignés comme les boucs émissaires pour une bonne partie des maux qui nous accablent. Le lecteur aura compris que si des chercheurs créateurs d'entreprises venaient à être accusés de gagner de l'argent ou de s'enrichir cela ne serait qu'un moindre mal. Un danger plus grave serait que, utilisant l'argument précédent comme un prétexte, la collectivité, inconsciente que nos problèmes sont dus en fait aux dysfonctionnements de notre système de recherche et de notre système économique dans son ensemble, refuse de se donner les moyens d'avancer plus vite sur la voie du progrès technique. Une telle attitude serait la manifestation d'une frilosité excessive et ne manquerait pas d'avoir des conséquences graves pour notre société. Ne nous y trompons pas ; le progrès technique n'est pas terminé et il est incontournable. Si nous le rejetons, ce sont les autres qui en seront les acteurs et les principaux bénéficiaires. Le but de ce chapitre est d'étayer cette thèse afin que, malgré les limites de l'esprit humain, les insuffisances de notre société et les imperfections de nos organisations, on n'en vienne jamais entraver le processus de découverte scientifique et le progrès technique qui doit nécessairement en découler.

Nous allons également voir dans ce chapitre que la science est habitée par

l'imprévu de sorte que la découverte scientifique s'avère être un processus de

nature essentiellement imprévisible. *

|

*

Voir

M. POLANYI, The Republic of Science, Minerva, Autumn 1962, vol.1, n°1,

p.54 ; cité par P.E. Stephan, The Economics of Science, J. of Economic

Literature, vol.34, Sept.1996, pp.1199-1235. |

Ceci signifie que l'on ne peut jamais, même par le plus grand effort d'imagination qui soit, réussir à imaginer le futur de manière un tant soit peu réaliste. Tantôt on pèche par excès lorsqu'on surestime les promesses du futur ; tantôt on pèche par défaut quand on les sous-estime. Le péché par excès est tellement bien connu que peu d'individus – les individus sensés bien sûr – le commettent : par exemple, croire qu'un jour l'homme pourra voler ou traverser les murailles ! Certains diront qu'il est provoqué par l'excès d'optimisme ou la crédulité ; par exemple, la crédulité de celui qui prend ses rêves pour la réalité (il convient cependant, comme nous le montrerons par la suite, de tempérer cette assertion par le fait qu'un rêve d'aujourd'hui peut fort bien devenir une réalité de demain). Le péché par défaut est, lui, commis beaucoup plus fréquemment : par exemple, penser qu'il est impossible de faire voler un objet plus lourd que l'air ! Certains diront qu'il est provoqué par l'excès de pessimisme ; par exemple, le pessimisme de celui qui se trouverait dans l'incapacité de rêver et/ou de croire à ses rêves sous le prétexte que les rêves ne sauraient se transformer en réalité. On sait pourtant que les spécialistes du sommeil disent que le rêve est indispensable à l'homme ; on pourrait ajouter : croire à certains d'entre eux aussi, car c'est cette attitude qui rend inventif. Robert (Bob) Kennedy disait "Certains voient les choses telles qu'elles sont et disent : pourquoi ? Je rêve de choses qui n'existent pas et je me dis : pourquoi pas ?". Une telle attitude est d'ailleurs tellement ancrée dans la culture américaine qu'elle est inscrite dans un dicton populaire qui dit à peu près ceci : "Comme il ne savait pas que ce qu'il voulait faire était impossible, il l'a fait". Et voici un grand mot de lâché : impossible. Un autre grand mot est : jamais. C'est Auguste Comte *

|

* Auguste Comte

(1798-1857), polytechnicien et philosophe, apôtre du positivisme, ce culte

de la science triomphante, niait par ailleurs l'existence des cellules,

constituants essentiels de tout tissu vivant végétal ou animal. Son

mouvement (Marcellin Berthelot en était un autre gourou et Jean Jaurès y

adhérait comme auditeur) récusait l’utilisation de moyens instrumentaux

comme le microscope ou le télescope au motif que ceux-ci modifiaient la

vue de l’observateur ! |

qui affirmait en 1844 qu'on ne pourrait jamais connaître la composition des étoiles et des planètes. Et puis Kitchhoff et Bunsen inventèrent le spectroscope, ce qui rendit notamment possible l'étude des étoiles sans avoir à y mettre les pieds, mission qui eût été, il faut bien l’avouer, ô combien périlleuse.

Il est indéniable que les rêves et les mythes constituent de puissants ressorts pour la créativité. Or, les scientifiques sont aussi comme tous les autres êtres humains : ils subissent l'influence des mythes et il leur arrive de rêver ou d'espérer *.

|

* Ce qui revient un peu

au même puisque, si l'on en croit Aristote, l'espérance est le rêve des

gens éveillés. |

Mais lorsqu'ils travaillent, ils laissent généralement leurs rêves de côté pour s'efforcer de devenir des esprits aussi froidement rationnels que possible. Ils partent de ce qu'ils savent – ou croient savoir – (état de la connaissance, théories et modèles existants), se posent des questions, observent, expérimentent, reformulent leurs questions ou celles que leurs collègues se sont posées, analysent des résultats et sont amenés ainsi à faire des découvertes. Il est intéressant d'observer que le hasard a joué un rôle magistral dans bon nombre de découvertes scientifiques majeures ; les erreurs aussi. A tel point même que l'on a pu dire que la fonction de la recherche fondamentale est de fournir des réponses à des questions que l'on n'a pas posées.

1. L’ILLUSION DE LA FIN DE LA SCIENCE

Vers la fin du XIXe siècle, de très grands scientifiques considéraient que l’édifice de la physique était quasiment achevé. C’est ce qui a pu faire dire en 1887 à Marcellin Berthelot, célèbre chimiste français (1827-1907), mais aussi pourfendeur des atomistes (autre prise de position contestable !) : "L’univers est désormais sans mystère." *

|

* Cette déclaration est

parfois rapportée sous des formes diverses. Ainsi, selon d'autres sources,

Berthelot aurait affirmé : "Grâce à la science, la connaissance de

l'Univers est désormais achevée." Ceci ne change rien, bien entendu, à

notre démonstration. |

C’était la "fin de la physique" ; certes, on allait améliorer par ici, peaufiner par là, mais l’essentiel était fait : on avait terminé de faire les grandes découvertes... Et l’avenir a donné tort à ces prophètes. Coup sur coup, ou presque, Röntgen découvre les rayons X (1895), Marconi découvre (brevet déposé en 1896) que les ondes radio peuvent porter à de plus grandes distances que les quelques dizaines de mètres que l’on croyait, Becquerel (1896) découvre la radioactivité*.

|

* En fait, le mot

"radioactivité" sera forgé par Marie Curie, découvreuse du radium en

1898. |

Vers la même époque, Clément Ader réussit à faire décoller (1890) un avion à vapeur. *

|

* La réalité de ce

"décollage" de 20 centimètres sur une distance de 50 mètres environ reste

controversée. |

Au même moment, le moteur à explosion à quatre temps dont le principe est découvert en 1862, fait des progrès considérables et rendra possibles (période 1883-1890) l’automobile et, plus tard (avec les frères Wright en 1903), l’avion moderne. La face du XXe siècle en a été complètement changée, rendant caduques les prévisions des futurologues du siècle précédent qui prévoyaient, à cause du développement inouï de la circulation à traction animale, que les rues des grandes villes du monde développé seraient bientôt recouvertes par plusieurs dizaines de centimètres de... crottin de cheval. *

|

* Appel aux

lecteurs : à cause de mes très (trop) nombreux déménagements

professionnels (une dizaine de 1990 à 1997), signe d'un harcèlement

certain J dont j'ai

été victime, j'ai égaré la référence précise (auteur, livre ou revue,

etc.) ; je remercie donc par avance toute personne qui saurait la

retrouver de bien vouloir me le signaler et me la faire parvenir par tout

moyen à sa convenance. |

On voit donc ce que peuvent espérer faire les spécialistes de prospective : extrapoler dans le futur les courbes qui se dessinent sous leurs yeux, celles-ci étant réalisées grâce aux données extraites du passé. Peu d’entre eux sont capables de discerner (mais qui en est capable ?), dans le bruit de fond de l’activité scientifique et technique, les faits réellement porteurs d’avenir. Ils doivent, de plus, s’efforcer de garder à l’esprit que, comme l’assure Bill Gates, le patron de Microsoft, "Il y a une tendance à surestimer ce qui peut arriver dans deux ans et à sous-estimer ce qui va se passer dans dix."

Il est indéniable que l’énergie électrique a révolutionné le monde. La première grande station de production d’électricité à haute tension a été réalisée à Londres en 1887-89. Quel savant de l’époque – même parmi les plus cultivés – aurait été capable de mesurer la portée réelle d’un tel événement ? Erasmus Wilson, professeur à Oxford, n’avait-il pas affirmé en 1878 que "Lorsque la foire internationale de Paris fermera ses portes la lumière électrique s’éteindra avec elle et l’on n’en entendra plus jamais parler." *

|

* Cité par Victor

NAVASKY, Courrier International, n°320-321, 19 décembre 1996, p.58.

L'auteur, journaliste américain, est coauteur avec Christopher CERF, de

l'ouvrage The Experts Speak: The Definitive Compendium of

Authoritative Misinformation. |

De la même manière, quelques années plus tard, qui aurait pu réellement écrire de plausibles scénarios pour le futur prévoyant le rôle qu’allaient y jouer les aciers spéciaux, l’aluminium, la radio, l’électroménager, le silicium ? Probablement peu de gens, car pour cela, il aurait fallu être au courant de beaucoup d’autres choses dans des domaines extraordinairement variés. Il aurait fallu savoir que trois nouveaux procédés de fabrication de l’acier (ceux de Bessemer, Martin, et Thomas-Gilchrist), mis au point de 1856 à 1880, vont en faire baisser le coût de production de 80 à 90 % de 1860 à 1890 ; que William Siemens vient d’inventer (1878) un four métallurgique à l’électricité permettant un contrôle très fin sans lequel le développement des aciers spéciaux d’abord, puis d’autres alliages, et enfin du silicium électronique aurait posé de sacrés problèmes ; que le procédé électrolytique de production de l’aluminium de Hall aux États-Unis et Héroult en France (1886) va rendre possible l’utilisation industrielle à grande échelle de ce métal ; que la lampe électrique à incandescence inventée par Thomas Edison en 1876 va faire littéralement "exploser" l’éclairage *

|

* Remarquons

au passage que l'électricité n'a pas été découverte en cherchant à

améliorer la chandelle. L'ex-ministre de la recherche Claude Allègre avait

repris urbi et orbi cet exemple didactique mais il n'en est pas l'auteur.

: toute information sur l'identité de

son véritable auteur (avec références) serait grandement

appréciée. |

chez les particuliers et dans les rues des villes avec le développement des réseaux de distribution de courant alternatif ; que l’invention des lampes électroniques (1906) trouvera une application de choix dans la radio ; et tellement d’autres choses encore. Qui aurait pu prévoir enfin que la production mondiale d’électricité hydraulique passera de 510 millions de kwh (c’est-à-dire 800 000 tonnes d’équivalent-charbon) à 120 milliards de kWh (100 millions de tonnes d’équivalent-charbon) de 1913 à 1929 et que ceci changera de manière indélébile la physionomie de la planète toute entière ?

2. LA MÉFIANCE ENVERS LE PROGRÈS TECHNIQUE

Si la créativité, c’est-à-dire, au fond, le goût pour la nouveauté, est bien ancrée dans la nature humaine, la peur du changement l’est tout autant. C’est le goût pour la nouveauté, stimulé par l’esprit d’imitation, qui a permis la diffusion des innovations et le progrès technique. La peur du changement, elle, est inscrite aussi bien dans les individus que dans les structures sociales et Louis Armand, président de l’Euratom de 1957 à 1959, avait remarqué que "le danger n'est pas le progrès technique, c'est l'inertie des structures." Ceci ne doit pas surprendre : toute structure (ou toute organisation) possède une histoire et n’est pas autre chose que le résultat d’actions qui s’inscrivent dans un contexte donné ; portant l’empreinte de ce contexte, de cet environnement, une structure aura tendance à rejeter tout ce qui est étranger à ce contexte et qui risque de perturber ou de remettre en cause son mode de fonctionnement normal. Paul Valéry, ce génial touche-à-tout, dans une fulgurance de visionnaire, a écrit "ce qui gêne l'innovation c'est ce qui existe déjà" faisant écho en cela à Claude Bernard convaincu que "c’est l’ancien qui nous empêche de comprendre le nouveau." Au-delà de ce qui est beaucoup plus qu’une simple boutade, on entend souvent dire que l’innovation dérange les organisations existantes (et ceci est d’autant plus vrai que l’organisation a un fonctionnement rigide ou une taille importante, les deux allant souvent de pair) car elle perturbe leurs habitudes, leurs routines. C’est la raison pour laquelle elle a tant de difficulté à s’imposer et a tendance à être facilement rejetée, éliminée comme un corps étranger pourrait-on dire. C’est aussi la raison pour laquelle elle a tendance à apparaître et à mieux s’exprimer dans les organisations de petite taille (les petites entreprises sont souvent plus innovatrices – en tout cas elles innovent plus facilement – que les grosses).

Le rejet du progrès technique prend souvent des aspects inattendus. Ainsi, durant les débats électoraux qui ont émaillé régulièrement la dernière crise économique et sociale. Afin de faire diminuer le chômage, certains hommes politiques avaient même suggéré de relancer les "petits boulots". On a proposé ainsi de remplacer par des hommes les péages automatiques des autoroutes ! Ce retour en arrière (comment qualifier autrement le fait de faire effectuer par des êtres humains un travail bête et répétitif qui peut être fait par des machines ?) ne saurait bien évidemment pas constituer un quelconque progrès. Dans cette affaire on a mélangé deux choses : progrès technologique et progrès social. Remplacer l’homme par la machine chaque fois que cela est possible est un progrès technologique. Mieux répartir entre les hommes les fruits du progrès technologique est un progrès social et ceci suppose des... décisions politiques. Mais il s’agit là d’un autre problème qui sort bien évidemment du cadre de la présente étude.

L’auteur du présent document est profondément convaincu (mais comment peut-on être sûr de quoi que ce soit ?) que le progrès technologique est, sinon illimité, du moins bien loin d’être terminé. Il pense aussi que le progrès scientifique et technique est, de plus, infiniment souhaitable. Mais il ne faut pas se tromper de cible et bien se garder de tomber dans l’illusion scientiste qui, comme le dit Jean-Jacques Salomon, "consiste à concevoir la technologie comme un substitut aux choix sociaux et politiques".

Le progrès technique, de par son caractère perturbateur aussi bien pour les hommes que pour les structures, a tendance à mettre en danger et à faire voler en éclats les situations acquises, les rentes de situation, les monopoles dont bénéficient certains individus ou certaines organisations. De plus, comme il est souvent promu par des originaux, des marginaux, en tout cas des acteurs qui n’occupent pas des positions centrales au sein de l’establishment, il possède un caractère pouvant être qualifié de révolutionnaire ce qui permet de comprendre la méfiance dont il fait l’objet de la part des acteurs dominants avec lesquels il entre en concurrence et qu’il contribue à déstabiliser.

3. LE CONFORMISME DANS LA RECHERCHE

Selon Michel Crozier, le grand sociologue français contemporain, "La recherche et l'innovation sont des activités individualistes qu'on pourrait qualifier d'aristocratiques [...] qui exigent des comportements non-conformistes" de sorte que "le management (hiérarchique, bureaucratique ou du style business schools) des chercheurs étouffe la créativité" *.

|

* M. CROZIER, Peut-on

manager la recherche et l'innovation ?, Politiques et Management Public,

vol.12, n°2, juin 1994, p.13. |

Et pourtant, contrairement à ce que l’on pourrait penser et espérer, la recherche est une activité qui comporte beaucoup de conformisme. *

|

* Voir le livre :

Organisation de la recherche et conformisme scientifique, ouvrage

collectif dirigé par A. Esterle et L. Schaffar, PUF Nouvelle Encyclopédie

Diderot, Paris, 1994. En particulier les chapitres rédigés par M. MORANGE

sur les "effets de mode" en recherche (p.263) et par A. ESTERLE sur la

recherche vécue dans les laboratoires (p.287). |

En effet, on commence généralement sa carrière dans un laboratoire où l’on subit les influences de son maître, de ses collègues, de sa propre communauté scientifique, bref d’une certaine école de pensée. Ensuite, la publication des résultats doit respecter des canons qui varient d’ailleurs d’une discipline scientifique à une autre.

Aussi n’est-il pas étonnant que les non conformistes, les moutons noirs, les marginaux, les originaux, les têtes brûlées, les incompris dans l'organisation à laquelle ils appartiennent, bref, les déviants, jouent un rôle essentiel en matière d’innovation.*

|

* Cf. D. BLONDEL,

L'innovation pour le meilleur... et pour le pire, Hatier éd.,

Paris, 1990, p.131. |

Ce qu’Albert Jacquard exprime autrement en disant, dans son Éloge de la différence, que la réalisation du présent dépend de la moyenne, mais les promesses de l'avenir dépendent de la variance. Au passage, remarquons également à ce stade (mais ceci demanderait un plus ample débat) que l'innovation est l'art de rendre utile au commerce les inventions des autres (l'inventeur ne s'enrichit généralement pas ; l'innovateur oui).

Le conformisme, donc, est partie intégrante de la recherche. Il ne faut pas en faire un jugement de valeur ; ceci n’est ni bien ni mal : c’est ainsi, tout simplement. Mais ce phénomène a des effets pervers : notons d’abord que le conformisme est simultanément l’une des causes et l’une des conséquences du dogmatisme (ce point mériterait à lui seul une étude plus approfondie) ; les deux font en tous cas bon ménage : ils ralentissent parfois l’émergence d’idées réellement neuves et originales en les tuant en quelque sorte dans l’œuf à cause de la censure quasi impérialiste qu’ils sécrètent. Si l’on effectue des recherches dans des domaines trop exotiques ou si l’on s’écarte trop de la norme, point de salut. C’est ainsi qu’Harriet Zuckerman, sociologue à Columbia, a observé qu’aux États-Unis, la moitié des prix Nobel ont été les élèves de précédents lauréats du prix. Une autre confirmation du fait que même le Nobel n’échappe pas à certaines formes de contrôle institutionnel ou social réside dans le constat que de 1934 à 1940, aucun prix Nobel de physique n'a été décerné à un juif. Il existe donc, à toutes les époques, et sous toutes les latitudes, des sujets tabous. Souvenons-nous du "Et pourtant, elle tourne" de Galilée. Un autre exemple, moins connu celui-ci, de censure sociale – heureusement avorté ! – s’est produit le 13 janvier 1535, jour où François 1er, roi de France, signa une incroyable ordonnance qui interdisait l’imprimerie ! Et c’est la Sorbonne, effrayée par l’agitation culturelle et sociale provoquée par cette invention diabolique qui facilitait la propagation des idées neuves, donc subversives, qui poussa le roi à se décider. Il est probable que la méfiance envers Internet observée aujourd’hui dans certains milieux soit provoquée par les mêmes ressorts.

Les organisations, quelles qu’elles soient – l’Université comme les autres –, tendent à se défendre contre les nouveautés et les innovations. Certains domaines sont même considérés comme tabous (les fantômes, les soucoupes volantes et, plus récemment, la mémoire de l’eau ou la fusion froide) et celui qui décide de s’y intéresser le fait à ses risques et périls. C’est ce genre de constat qui a pu amener Anatole France à proclamer, sans doute de manière un peu provocatrice, que "les savants ne sont pas curieux". On pourrait ajouter qu’ils ne sont pas toujours parfaitement honnêtes non plus et les cas de tricheries ou autres manquements à l’éthique sont légion et ont parfois été commis même par les plus célèbres d’entre eux.

Pour terminer, il est bien évident que le contrôle social ne saurait, en soi, suffire à expliquer de moindres performances en matière d’innovation. Le Japon est, à cet égard, un contre-exemple patent. Ce pays, où le contrôle social est si fort que l’on a pu dire que c’est le règne du conformisme, *

|

* J.L. LEVET et J.C.

TOURRET, La révolution des pouvoirs. Les patriotismes économiques à

l'épreuve de la mondialisation, Economica éd., Paris, 1992,

p.96. |

a résisté mieux et plus longtemps que les autres aux ravages de la crise récente ; celle-ci ne l'a atteint qu'au milieu des années 90.

4. LE CONFORMISME N’EMPÊCHE PAS LES ERREURS

Nous avons vu dans ce qui précède que même le fonctionnement des instances qui attribuent le prix Nobel n’est pas à l’abri d’un certain contrôle social, lui-même source de conformisme. Or, comme nous allons essayer de le montrer ici, le conformisme n’est absolument pas une garantie contre le risque d’erreur. L’erreur, on le sait, est humaine et la sagesse populaire ajoute que les grands hommes font de grandes erreurs ; les savants aussi. *

|

* J.P. LENTIN, Je

pense donc je me trompe, Albin Michel, Paris, 1994. Ce livre décrit

les erreurs des grosses têtes pensantes de Pythagore à

Einstein. |

Il ne faut pas s’en offusquer. "Si vous fermez la porte à toutes les erreurs, la vérité restera dehors" disait Rabindranath Tagore.

Passons sur les cas – que l’on peut considérer comme individuels – de quelques grands savants du XIXe qui, comme Tesla, étaient convaincus que la planète Mars était habitée *

|

* P. FLICHY,

L'innovation technique, éd. La Découverte, 1995,

p.193. |

ou de beaucoup d'autres (Crookes, Richet, Flammarion) qui croyaient alors à la télépathie. *

|

* Interview (en fait une

interview à deux avec Nicolas Ptantzos) de Wiktor Stoczkowski (auteur de

Des hommes, des dieux et des extraterrestres, Flammarion édit.

J

justement, 1999) dans le Nouvel

Observateur, 29 juin 2000, pp.122-124. Sur le fond de l'affaire, et de mon

point de vue, l'existence ou la non-existence de phénomènes télépathiques

n'ont pas été démontrées de manière absolument définitive à ce

jour. |

Les communautés scientifiques elles-mêmes – en tant que telles – ne sont pas à l’abri des erreurs. Ainsi, le comité Nobel qui s’est fourvoyé dans l’attribution – contestable – de quelques-uns de ses prix. Parmi les cas les plus fameux, on peut citer :

- celui de 1917 attribué à Charles G. Barkla (Royaume-Uni) pour ses travaux sur le spectre de rayons X caractéristique des éléments ; Barkla découvrit par la même occasion les rayons J qui, comme chacun sait depuis, n'existent pas ;

- celui de 1927 à Johannes Filiger (Danemark) pour ses travaux sur un cancer qui s’est avéré par la suite être totalement hypothétique ;

- celui

de 1921 à Albert Einstein (Allemagne) lui a enfin été décerné – après une

dizaine d’années d’attente – pour l’explication de l'effet photoélectrique

alors qu'il avait été pressenti pour la théorie de la relativité (1912). Sans

doute le comité Nobel n’a-t-il pas osé prendre le risque de se ridiculiser en

le récompensant pour une théorie que bien peu de gens étaient capables

d’apprécier pleinement et qui – sait-on jamais ! – aurait pu s’avérer

erronée ; de plus, l’époque était plutôt à l’antisémitisme et comme

Einstein était juif... *

|

*

D.

BRIAN, Einstein. Le génie,

l'homme, Robert Laffont, 1997.

Une autre raison existe pour la nom nomination d’Einstein : des

travaux réalisés antérieurement par Poincaré antériorisaient ceux

d’Einstein. Ce fait est bien connu aujourd’hui mais on peut se demander si

cet élément était déjà si évident que cela aux yeux des membres du Comité

Nobel de l’époque. |

Les erreurs ci-dessus sont somme toute assez comiques car elles ne prêtent pas à grandes conséquences. Dans d’autres domaines, ceux touchant à la santé publique par exemple, les erreurs peuvent avoir des effets plus graves. Ainsi, sans épiloguer sur l’affaire du nuage radioactif originaire de Tchernobyl qui, selon nos élites, s’était arrêté miraculeusement aux frontières de l’Hexagone au mépris de toutes les lois de la météorologie, on se contentera de mentionner dans l’histoire récente, les incohérences ou les mauvaises décisions des pouvoirs publics en matière de sida, ou à propos de la maladie de Creutzfeldt-Jakob (affaire de l’hormone de croissance humaine), ou encore dans l’affaire de la vache folle.

Comparé aux personnes impliquées dans les cas ci-dessus, Serge Voronov (ou Voronoff), professeur au Collège de France, qui, dans les années vingt, greffait des testicules de singes sur des vieillards pour les empêcher de vieillir peut être regardé comme un doux rêveur. A ce compte, le grand physiologiste français Adolphe Brown-Séquard aussi, lui qui, jouant le rôle du cobaye, s’est injecté en 1889 des extraits de broyat de testicules de mouton. Le lecteur est prié de ne pas rire des tentatives de ces pionniers : récemment on a bien en effet tenté (sans succès ; mais, compte tenu des progrès à venir, jusqu’à quand ?) de greffer un coeur de singe sur un nouveau-né (en 1984) et un foie de porc sur une jeune Américaine (en 1992).

Dans le domaine industriel, les erreurs d’appréciation peuvent avoir des conséquences stratégiques considérables. Ainsi, lorsque la société Bertin était engagée dans le développement de l’aérotrain, l’argument décisif utilisé alors par la SNCF pour tuer le projet fut son estimation du marché sur la ligne Paris-Lyon : il n'y avait pas un trafic prévisible susceptible de justifier la réalisation d'une nouvelle liaison qui aurait mis les deux villes à une heure un quart l'une de l'autre, même avec un ou deux arrêts intermédiaires. *

|

* J. BERTIN et R.

MARCHAL, L'aérotrain ou les difficultés de l'innovation,

Bibliothèque Aviation International Magazine, coédité par la Sté des Amis

de Jean Bertin et la société Bertin & Cie, 1989 (2° éd.),

p.39-40. |

Or, le TGV met actuellement ces deux villes à deux heures l’une de l’autre (et souvent sans aucun arrêt intermédiaire !) et le marché semble être porteur.

Dans le domaine de la recherche, des erreurs d’appréciation peuvent également entraîner des conséquences difficiles à calculer. Ainsi, Jean Perrin, qui, à 24 ans, prouva l’existence de l’électron, qui fut par la suite le père-fondateur du CNRS et le créateur du Palais de la Découverte à Paris, refusa l’application de la mécanique quantique à la chimie. Cette toquade ralentit les progrès de la chimie française au point que ce grand homme peut en être regardé comme l’un des principaux responsables. *

|

* M. CHARPENTIER-MORIZE,

Perrin, savant et homme politique, Belin édit., 1998. |

Parmi d’autres exemples d’erreurs de toute première grandeur ou de fausses découvertes citons les rayons N de Blondlot *

|

* Ces rayons, soi-disant

émis par les tubes cathodiques, certains métaux chauffés au rouge ou

certains matériaux soumis à une compression, étaient décrits comme

possédant des propriétés curieuses. |

en 1903 ; ou encore les rayons mitogénétiques en 1923, l’effet Allison

en 1927 et l’interprétation inexacte de l'expérience de Davis et Barnes en 1929.

*

|

*

Exemples

simplement cités sans références par E.F. MALLOVE, Fire from Ice,

Searching for the Truth Behind the Cold Fusion Furor, John Wiley,

N.Y., 1991. |

5. COMMENT LES IDÉES NEUVES FINISSENT PAR S’IMPOSER

Pourtant, le progrès scientifique et technique existe bien ce qui signifie que les idées neuves, lorsqu’elles ne sont pas erronées, finissent par s’imposer. Il convient peut-être ici de faire la distinction entre les grandes idées, les innovations révolutionnaires et les petites innovations, celles qui ne constituent que des avancées plus modestes. La grande innovation, la percée – ce que l’on nomme parfois innovation de rupture –, est ce que les Anglo-Saxons appellent "breakthrough". Pour Nayak et Ketteringham, les percées surgissent de manière déstructurée, fruits des hasards, "fruits de l'esprit" par opposition au milieu. "La percée dépasse le milieu et l'environnement dans lesquels elle surgit." Elle provient d'abord d'un individu ou d'un groupe qui subissent par là une véritable mutation et s'en trouvent changés eux-mêmes... avant que d’aller changer les autres domaines scientifiques et, éventuellement, le reste du monde. *

|

* Cf. par exemple : P. R.

NAYAK et J. M. KETTERINGHAM, 12 idées de génie auxquelles personne ne

croyait, First inc. édit., Paris, 1987. |

Il faut observer que la grande masse des individus a tendance à ne pas trop sortir des sentiers battus. En ce qui concerne l’innovation, c’est-à-dire, en définitive, la production et la mise en pratique des idées neuves, il est intéressant de remarquer l’importance des rôles joués par le hasard, les marginaux, et les jeunes d’esprit.

Concernant le hasard, l’histoire des sciences et des techniques est riche d’exemples – des plus fameux aux moins connus – où un événement fortuit, une erreur, une négligence même, ont été à l’origine de très grandes découvertes. *

|

* De nombreux très beaux

exemples sont reportés dans l'ouvrage de F. LOT, Les jeux du hasard et

du génie, Plon édit., 1956. |

S’il est vrai en apparence que l’on ne peut pas grand chose sur le hasard, on observera que des procédures trop bien figées, des routines trop précises, des théories ou des censures trop parfaites, limitent l’apparition ou la prise en compte des faits produits par le hasard. On observera également que le hasard n’est pas tout et que la découverte reste aussi le fruit d’une rencontre entre un fait – une observation plus ou moins fortuite ou le résultat d’une expérience –, et un esprit capable d’en tirer ce que d’autres n’avaient pas su voir avant. Le rôle de l’esprit étant ici d’être capable de discerner, parmi tous les faits produits par le hasard, celui ou ceux réellement significatifs et féconds et ceci va de pair avec le maintien, chez le scientifique, d’une bonne et durable capacité d’étonnement. Enfin, cet accent mis sur le hasard ne doit pas dissimuler que très souvent aussi, le travail – beaucoup de travail et de réflexion – joue un rôle essentiel et irremplaçable. Comme on a pu le dire : le génie c’est 5 % d’inspiration et 95 % de transpiration !

Concernant les marginaux, ou à tout le moins les originaux, précisons qu’il s’agit ici d’individus qui ne se situent pas tout à fait – par leurs idées, leurs attitudes, leurs comportements – dans ce que l’on pourrait appeler la norme commune. Ce sont des gens qui se caractérisent souvent par des trajectoires, des expériences, bref une histoire personnelle, se démarquant plus ou moins fortement de celles de leurs contemporains. D’une certaine manière, ce sont des gens qui ne se situent pas au centre du monde habituel mais qui sont en contact avec (ou évoluent sur) ses marges, sur ses bords ou près de ses frontières. Le fait de vivre sur la frontière (au sens du mot américain : the Frontier) ou d’y aller plus ou moins souvent les fait rencontrer et côtoyer des mondes, des situations ou des problèmes différents pour lesquels les référents habituels ne sont pas d’un très grand secours ; ils devront faire face ou seront obligés de gérer ces situations de manière originale, donc parfois novatrice.

Concernant les jeunes d’esprit, il convient de remarquer que la jeunesse est d’abord une caractéristique psychologique avant que d’être une propriété physique liée à l’âge. On peut être jeune – ou vieux ! – à tout âge. Ainsi, c’est à 24 ans que Newton invente le calcul infinitésimal, précise la nature de la lumière blanche et conçoit la théorie de la gravitation universelle ; c’est à 33 ans que Frédéric Joliot découvre avec sa femme Irène Joliot-Curie (36 ans) la radioactivité artificielle. Mais c’est à 50 ans que Röntgen découvre les rayons X ; et Faraday, qui découvre l’induction électromagnétique à 40 ans, essaie encore, à l’âge de 70 ans, d’identifier les effets d’un champ magnétique sur les raies du spectre atomique (l’expérience échoue et sera réussie 35 ans plus tard, en 1896, par Zeeman). Cependant, on peut considérer en moyenne, que les jeunes sont beaucoup plus ouverts que leurs aînés aux idées neuves ; ils les adoptent plus vite et plus facilement et le domaine de la mode (vestimentaire, musicale, alimentaire, en matière de moeurs, etc.) est particulièrement illustratif. Pour le dire de manière plus provocatrice : les vieux regardent l'obstacle, les jeunes voient au-delà. A titre d’illustration amusante, on peut mentionner la découverte des quasars. Officiellement, elle a été réalisée par Maarten Schmidt en 1961. Mais en réalité, l’année précédente, Thomas Mattews, élève de Jesse Greenstein (observatoire de Pasadena) avait proposé une interprétation qui allait dans ce sens pour expliquer un certain nombre de résultats d’observation. Mais l’idée était tellement nouvelle, donc révolutionnaire, que son patron n’y avait pas cru et avait préféré la rejeter.

Lorsqu’une idée neuve surgit, la question qui se pose est de savoir si elle

va finir par s’imposer, et comment. Le grand physicien allemand Max Planck

(1858-1947), père de la physique quantique, avait sa propre opinion pour ce qui

concerne les idées scientifiques : "a new scientific truth does not

triumph by convincing its opponents and making them see the light, but rather

because its opponents eventually die, and a new generation grows up that is

familiar with it. " *

|

*

M.

PLANCK, Scientific autobiography and other papers, Philosophical

Library, New York, 1949, p.33-34 ; cité par P.E. Stephan, The

Economics of Science, op. cit. |

Cette formulation du Principe de Planck entraîne deux remarques : (i) ce principe contribue à expliquer pourquoi les idées neuves, les découvertes majeures, les technologies et les produits nouveaux mettent autant de temps pour s’imposer ; (ii) il n’existe pas de raisons particulières pour que ce principe soit limité au domaine des idées et des découvertes scientifiques. En cela, le Principe de Planck n’est qu’une manière particulière, quelque peu provocatrice et un tantinet réductrice, de traduire en termes démographiques la méfiance fondamentale, intrinsèque, presque génétique pourrait-on dire, des hommes et des organisations envers le progrès technique.

6. L’IMPORTANCE DU FACTEUR TEMPS

La complexité du processus qui permet à une idée neuve de s’imposer met en évidence l’importance du facteur temps. En effet, tout processus est un phénomène temporel et, en tant que tel, demande un certain temps pour pouvoir se réaliser. L’avancée des idées en matière scientifique illustre très bien ce propos.

Par exemple, on sait que les rayons X ont été découverts par Röntgen en 1895. Pourtant, huit ans après, Lord Kelvin, alors président de la Royal Society, était toujours convaincu qu’il s’agissait d’une mystification. *

|

* William Thomson, alias

lord Kelvin (1824-1907), co-découvreur à l'âge de 28 ans de l'effet

Joule-Thomson et père de l'échelle absolue de température, niait que

l'hélium puisse se former lors de la désintégration du radium et a cru

toute sa vie à l'indivisibilité des atomes. |

Toujours vers le début du siècle, Ernst Mach (1838-1916), qui a donné son nom au nombre de Mach utilisé en aéronautique supersonique, déclarait qu’il n'est pas scientifique de s'intéresser à des choses hypothétiques comme des atomes qui sont des objets que l'on n'observe pas directement ; à noter au passage que l’extrémisme de l'opinion des anti-atomistes n’a sans doute pas été pour rien dans le suicide de Boltzmann en 1906. *

|

* Ludwig Boltzmann

(1844-1906), principal créateur de la théorie cinétique des gaz et père de

la mécanique statistique, l'un des rares savants germaniques à avoir

résisté au dogmatisme de la phénoménologie, fut très controversé dans son

pays. Il sombra dans la neurasthénie et devint sujet à de fréquentes

dépressions qui l'amenèrent à mettre fin à ses jours. |

Dans le domaine des sciences de la Terre, Wegener a exprimé sa théorie de la dérive des continents en 1912 ; pourtant on n'a vraiment commencé à y croire (sous la forme plus élaborée de tectonique des plaques) dans les milieux concernés qu’à partir du début des années 70. L’énergie atomique est un autre domaine où les idées ont mis longtemps pour s’imposer. Ainsi, Henri Poincaré (1854-1912) a toujours douté de la possibilité de tirer de l’énergie du noyau atomique et a fortiori "de détruire une ville avec une livre de matière" mais il est vrai qu’il était plus mathématicien que physicien. Albert Einstein, pour sa part, pensait toujours en 1932 : "Il n’y a pas la moindre indication que l’on puisse obtenir un jour de l’énergie nucléaire". *

|

* Le même Einstein aurait

déclaré maintes fois qu'il est plus facile de briser un atome qu'un

préjugé ! |

Et ceci, seulement 2 ans avant qu’Enrico Fermi (1901-1954) n’obtienne à Rome la première réaction de fission nucléaire (mais il ne sut pas alors interpréter correctement l’expérience qu’il venait de réaliser : il crut à l’époque avoir créé par transmutation des éléments transuraniens). L’idée même de fission nucléaire eut beaucoup de mal à s’imposer et un article d’Irène Joliot-Curie de 1938 qui soutenait cette hypothèse était vigoureusement combattu par Otto Hahn (1879-1968) à Berlin ; ce même Hahn, enfin convaincu, changea d’avis la même année et est reconnu aujourd’hui (avec Strassmann) comme le père de la théorie de la fission de l’uranium ! Il est aussi intéressant de noter que la fameuse déclaration d’Einstein sur l’impossibilité d’obtenir de l’énergie nucléaire fut faite 10 ans avant que Fermi ne fasse diverger la première pile atomique à Chicago et 13 ans avant que la première bombe atomique n’explose dans le désert du Nouveau-Mexique. Observons que 3 ans pour passer de la première divergence en laboratoire à la bombe est un temps remarquablement court qui ne peut s’expliquer que par le colossal effort de guerre américain qui sous-tendait le projet Manhattan : il fallait à tout prix réussir avant l’Allemagne nazie. En temps normal, on est en droit de penser qu’il eût fallu beaucoup plus de temps. Ainsi, plus près de nous, et en l’absence d’un enjeu stratégique comparable, si la première émission laser a été obtenue en 1960 il a fallu attendre 10 ans avant de voir la première application du laser – gravure de circuits intégrés en micro-électronique. Et ce n’est que vers 1980 que l’on a commencé à voir des lasers percer, découper, souder à des cadences véritablement industrielles.

A travers des nombreux exemples que nous avons cités, on constate le rôle négatif, néfaste même, qui a pu être joué par quelques grands savants qui ont ainsi contribué à freiner le progrès scientifique. Le processus est relativement simple : grâce à l’immense prestige qui les entoure, ces grands noms de la science deviennent de véritables gourous qui ont forcément toujours raison et dont la pensée ne saurait être remise en cause ou contredite par quiconque et surtout pas par des blancs-becs inexpérimentés. Ce qu’ils disent est donc la vérité. C’est ce qui justifie que l’on fasse appel à eux pour donner leur avis ; et à la limite, on les sollicitera à propos de n’importe quoi y compris sur des questions pour lesquelles ils ne sont pas nécessairement les mieux placés pour répondre. Leur parole devient ainsi peu à peu parole d’évangile. A cause de ce que leur figure représente dans un domaine donné, les idées de ces grands scientifiques sont en mesure de gêner les avancées et les progrès dans d’autres domaines. Il semble ainsi exister une loi universelle selon laquelle le pouvoir de nuisance d’un savant envers l’avancée des idées varie comme sa célébrité.

Lord Kelvin fut véritablement de ces savants-là ce qui ne doit d’ailleurs rien enlever à ses mérites. Nous avons vu certaines de ses prises de position – sur l’existence des rayons X et sur celle des atomes – dont nous savons aujourd’hui qu’elles étaient contestables. En voici une autre sans doute moins connue mais qui a eu une grande influence sur l’idée que l’on se fait de l’âge du globe terrestre. Lorsque Charles Darwin *

|

* Charles Darwin

(1809-1882), naturaliste anglais. |

publia en 1859 son ouvrage intitulé De l’origine des espèces par voie de sélection naturelle, il estima que 300 millions d’années s’étaient écoulées depuis la fin de l’ère mésozoïque (que nous appelons aujourd’hui ère secondaire) alors que les géologues pensaient que l’âge du globe ne dépassait pas 100 millions d’années. Or, en s’appuyant sur des considérations sur la déperdition continue d’énergie thermique par la Terre, Kelvin estimait que notre planète ne pouvait pas avoir plus de 100 millions d’années. Le prestige et l’autorité de Kelvin étaient si grands que Darwin se sentit forcé de retirer des éditions ultérieures de son livre les exemples précis de durée qui contredisaient les dires du grand physicien. Plus tard, en 1897, Kelvin fit de nouveaux calculs en prenant en compte le fait que le soleil devait s’être lui aussi continuellement refroidi depuis son origine et il en conclut que la Terre s’était formée il y a 20 à 40 millions d’années seulement. Si les darwiniens en furent consternés il se trouva un certain nombre de géologues qui réduisirent aussitôt leurs estimations de la durée des temps géologiques. Ainsi les idées de Kelvin continuèrent leur action hégémonique au détriment de celles de Darwin bien après la mort de ce dernier. L’épilogue est tout aussi intéressant : ce n’est qu’en 1904, en écoutant une conférence sur la radioactivité dans laquelle un jeunot de 33 ans, Ernest Rutherford, *

|

* Ernest Rutherford

(1871-1937), natif de Nouvelle Zélande, découvrit en 1899 la radioactivité

du thorium et donna avec Soddy, en 1903, la loi des transformations

radioactives. |

parlait d’une pechblende (un minerai d’uranium) dont il avait estimé l’âge à 700 millions d’années que Kelvin, vénérable octogénaire, accepta de changer d’avis sur l’âge de la Terre. Rutherford concéda très diplomatiquement que les calculs antérieurs de Kelvin n’étaient pas faux mais ils ne tenaient pas compte d’une source de chaleur interne du globe terrestre qui était inconnue auparavant, la radioactivité naturelle des roches. Si on avait pu en tenir compte, alors on aurait trouvé que la Terre était bien plus vieille que cela. Aujourd’hui, on pense que la Terre s’est formée il y a 4 500 millions d’années !

7. INTELLIGENCE DE LA MÉTHODE OU MÉTHODE DE L’INTELLIGENCE ?

Comme nous l’avons amplement illustré, la nouveauté et l’innovation dérangent les hommes et les organisations. Or, les enjeux du monde moderne sont tels qu’il faut innover sans cesse, soit parce que contraints et forcés par la concurrence, soit plus simplement parce que le progrès technique est, depuis toujours, le gage et le fondement de l’amélioration de nos conditions d’existence. De surcroît, il est indéniable qu’innover suppose et demande des aptitudes et des attitudes particulières et ceci aussi bien de la part des individus que de celle des organisations. On peut légitimement penser qu’il doit être possible de cultiver ces attitudes et de trouver des méthodes pour améliorer les aptitudes.

"La découverte justifie, non seulement toutes les méthodes, mais aussi toutes les absences de méthode." notait Claude Bernard, ce grand méthodique qui conseillait de ne pas hésiter, à l’occasion, à aller pêcher en eau trouble. Il est bon "de se soumettre à toute une hygiène mentale, de respecter des temps de repos, de renouveler la curiosité et son inquiétude, de surveiller la raison pure, et d’interrompre la lecture d’un traité de chimie par celle du Grand Maulnes. La science a besoin de la poésie d’aventure." *

|

* Pierre Vendryès,

cité par Fernand LOT, Les jeux du hasard et du génie, op.

cit. |

Comme nous avons essayé de le montrer dans les paragraphes précédents, une attitude ouverte à l’innovation suppose un changement profond de nos habitudes, de nos réflexes ; elle suppose une modification de nos schémas de pensée, notre adaptation à une réalité fortement évolutive ainsi que l’apprentissage de nouveaux modes de fonctionnement sur les plans aussi bien individuel que collectif. Ce qui paraît s’approcher le plus de cet idéal est ce que les Grecs appelaient la "mètis".

"La "mètis" des Grecs est bien une forme d'intelligence et de pensée, un mode de connaître ; elle implique un ensemble complexe, mais très cohérent, d'attitudes mentales, de comportements intellectuels qui combinent le flair, la sagacité, la prévision, la souplesse d'esprit, la feinte, la débrouillardise, l'attention vigilante, le sens de l'opportunité, des habiletés diverses, une expérience longuement acquise ; elle s'applique à des réalités fugaces, mouvantes, déconcertantes, et ambiguës qui ne se prêtent ni à la mesure précise, ni au calcul exact, ni au raisonnement rigoureux". *

|

* M.DETIENNE et J.P.

VERNANT, Les ruses de l'intelligence, la mètis des Grecs, cité

par J.L. LE MOIGNE dans son ouvrage Intelligence des mécanismes,

mécanismes de l'intelligence, p.42. |

Méthode de l’intelligence ou intelligence de la méthode ?

Il s’agit ainsi d’abord de promouvoir un véritable développement des aptitudes et des capacités des individus. Mais au-delà des individus, on aura compris qu’il s’agit d’une véritable gageure : concilier des comportements éminemment individualistes, voire selon nos critères actuels, non-conformistes, avec une cohérence d’ensemble qui permette au corps social tout entier d’en tirer les bénéfices de manière collective afin, notamment – et le problème est d’actualité –, de limiter les exclusions. Le progrès technique ne saurait simplement servir les intérêts d’un petit nombre ou être récupéré par quelques-uns : il doit profiter à tous, ou en tous cas, au plus grand nombre afin de réconcilier "science" et "conscience".

Lorsque l’on lit les écrits de nombreux sociologues, économistes, spécialistes d’autres sciences humaines, on est frappé par la récurrence d’expressions telles que : "le particularisme français", "la spécificité française", "la singularité française", "l’exception française", "le modèle français", "le cas français". Ces expressions qualifient tel ou tel aspect de notre construit social, de son fonctionnement et trouvent leur justification dans les modes de fonctionnement originaux, particuliers, de nos institutions, de nos organisations. C’est ce que l’on appelle parfois pudiquement le modèle sociétal français et les conséquences de ces modes particuliers de fonctionnement se manifestent dans tous les rouages de la machine France avec çà et là des effets non souhaités ou des dysfonctionnements.

De telles caractéristiques ne peuvent pas ne pas avoir d’incidence sur la manière dont la France gère les tensions entre le nouveau et l’ancien, l’innovation en général (qu’elle soit d’ailleurs technologique ou sociale !), l’émergence de nouvelles technologies, la manière utilisée pour les mettre ou non au service du plus grand nombre ainsi que les tensions sociales et les arbitrages politiques auxquels ces processus donnent naissance.

Les choses sont criantes dans les dossiers sensibles, là où l’opinion publique est prête à se mobiliser et éventuellement s’enflammer, comme celui de la santé publique. C’est à propos de ce dossier qu’Aquilino Morelle a pu écrire : "En France, le probable est toujours tenu – jusqu'à preuve du contraire – pour faux. Alors que décider revient à anticiper le pire et à le considérer, en principe, comme possible." *

|

* A. MORELLE (énarque,

professeur à l’IEP de Paris et accessoirement "nègre" de Lionel Jospin),

La Défaite de la santé publique, Flammarion édit. |

Dans des domaines moins sensibles, mais également lourds au plan économique et prospectif, les choses sont tout aussi prégnantes. Ainsi, beaucoup d’espoirs sont mis actuellement sur les développements futurs d’Internet. Il est indéniable que l’avance américaine dans ce domaine est peut-être irrattrapable. Et pourtant : en 1969, alors que le projet qui allait donner naissance à Internet ne faisait que balbutier et ne reliait encore que les laboratoires américains de recherche travaillant pour la défense, en France on réfléchissait aussi. En 1973, il a même existé un projet français équivalent (projet Cyclades) que le ministère de l'industrie a fait abandonner car il a été jugé à l’époque sans aucun avenir !

Les choses sont encore plus criantes en matière de microinformatique. A-t-on oublié que c’est à deux Français que l’on doit le premier microordinateur ? C’est François Gernelle qui l’invente et André Thi Truong qui fabriquera ensuite, en 1973, le Micral N au sein de la société R2E. Cependant, la microinformatique a ensuite été développée ailleurs. Il est intéressant de remarquer que ce n’est pas la société IBM, le géant de l’informatique, qui a joué ce rôle d’entraînement mais que c’est la contre-culture (structures sociales dites "alternatives") américaine de la côte Ouest des États-Unis (Californie) en pleine guerre du Viêt-nam qui a été à l’origine des développements qui ont abouti à la création de la société Apple par Steve Jobs et Stephen Wozniak. *

|

* P. FLICHY,

L'innovation technique, édit. La Découverte, 1995. |

On signalera ici, sous forme de parenthèse amusante, que le capital-risque a été inventé après la deuxième guerre mondiale aux États-Unis par un Français, Georges Doriot, qui s’était établi là-bas dans les années 20. *

|

* R. LATTES, Le

risque et la fortune, J.Cl. Lattès édit., Paris, 1990,

p.207. |

S’il est vrai, comme le dit le vieil adage, que "nul n’est prophète en son pays", on pourrait ajouter : en France moins qu’ailleurs. Et l’on ne compte plus le nombre de nos concitoyens qui ont déclaré avoir dû s’expatrier pour pouvoir réaliser un projet que le "système français" ne leur permettait pas de mener à bien. Pourquoi la France est-elle donc apparemment si rétive à l’innovation ? Il convient, pensons-nous, de nous pencher sur certaines de ses spécificités ; en l’occurrence sur les facteurs qui, chez nous, jouent un rôle central et crucial sur la formation et la maturation des (jeunes) consciences à savoir certains aspects de notre organisation scolaire et éducative. Il n’est plus très original aujourd’hui d’affirmer que le système éducatif français est trop élitiste et trop tourné vers la théorie et l’abstraction. Le rôle hégémonique des mathématiques est particulièrement apparent dans notre système de sélection qui est centré sur les maths. Le rôle de l’État, des élites, de l’establishment, est très important, peut-être excessif, et l’effet de censure qui en résulte est étouffant pour l’esprit d’entreprise. La France réussit assez bien dans les grands programmes (que l’on songe au programme électronucléaire, au supersonique Concorde, au TGV, au Minitel, etc.) là où l’État est fortement moteur, mais rencontre pas mal de difficultés dans les domaines moins ambitieux, et dans l’innovation en général. Ce n’est donc pas un hasard puisque ces domaines sont au contraire les terrains d’élection des petites équipes, des commandos, voire d’individus hyper-créatifs (cf. par exemple l’invention de la carte à puce par Roland Moreno au milieu des années 70).

Il faut, avant d’aborder la question : quels scénarios possibles pour le futur ? faire un acte de foi. Le futur devra nécessairement – et tous les efforts devront aller dans ce sens – s’inscrire sous le signe du progrès. Commençons par une citation, peut-être un peu longue, mais qui a l’ambition de vouloir cadrer la problématique :

"S’interroger sur le progrès, c’est interroger sur le sens de l’activité humaine.

Le progrès est un concept culturel occidental, absent chez d’autres peuples. C’est une idée relativement récente dont la connotation n’a pas toujours été positive. Le " progrès ", loin d’être assimilable à l’Histoire, a donc lui-même une histoire.

Au Moyen-âge la notion désigne l’évolution spirituelle du genre humain qui devait conduire à l’avènement de la cité de Dieu. C’est à la Renaissance que l’idée de progrès s’écarte de la recherche d’un gouvernement spirituel du monde pour se structurer autour de l’avancement des sciences et des techniques. Dès lors le progrès se définit davantage comme le résultat d’une accumulation de connaissances où la raison le dispute à la foi. Au siècle des Lumières, le débat est loin d’être tranché : le progrès est-il matériel ou moral ? Linéaire ou discontinu ? Limité ou infini ? C’est au XIXe siècle surtout que l’on assignera au rationalisme, à la science érigée en nouvelle croyance, le soin d’apporter bonheur, justice et prospérité.

Diderot doutait : " Le monde a beau vieillir, il ne change pas ; il se peut que l’individu se perfectionne, mais la masse de l’espèce ne devient ni pire ni meilleure. "

Malgré ce dont l’homme est capable dans le domaine de l’horreur, l’idée que l’humanité est appelée à devenir de jour en jour meilleure, fonde pourtant l’interprétation de l’Histoire en Occident. Illusion ? Illusion nécessaire peut-être ?" *

|

* Plaquette de

présentation du colloque "Les entretiens de la communication scientifique

et technique", Paris, 29 janvier 1997. |

Le futur est quelque chose de nouveau qui s’invente et que personne n’avait prévu, ni même imaginé. Pourtant l’exercice consistant à écrire des scénarios sur l’avenir reste utile car comme l’a dit Pascale Weil (de la société Publicis) : "En écoutant les prévisions, on en apprend plus sur aujourd’hui que sur demain" ; ce qui n’est déjà pas si mal que cela.

Dans ces conditions, vouloir écrire des scénarios pour le futur relève d’une impossibilité fondamentale. On peut cependant – peut-être – essayer d’éclairer quelques zones d’ombre en partant de l’idée que le progrès technique est loin d’être terminé et que les capacités technologiques de l’espèce humaine sont encore loin de leurs limites – si limite il y a. Raisonner autrement nous cantonnerait dans une attitude de "fin de la physique" comme celle que nous avons vue être adoptée vers la fin du XIXe siècle, même – et surtout dirais-je – par les plus grands scientifiques de l’époque. Il est donc fort probable que de très grands progrès soient encore devant nous.

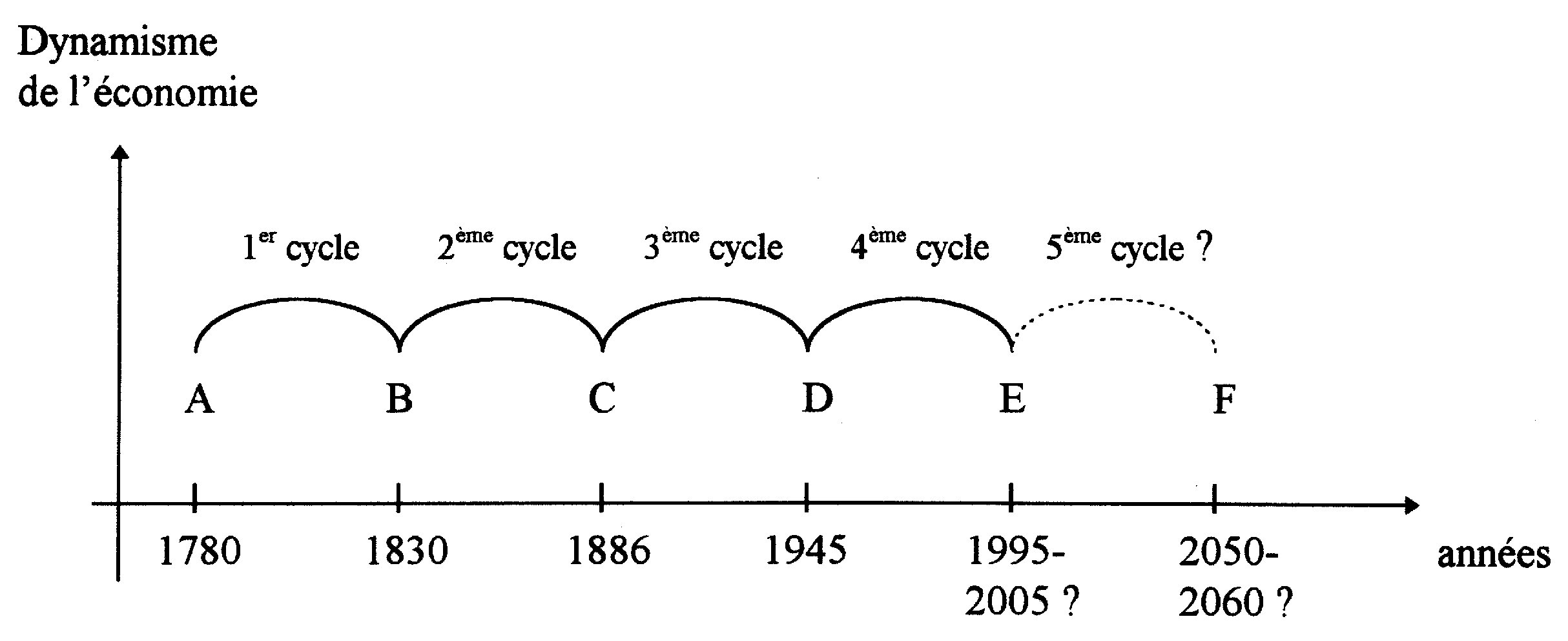

En observant les grandes pulsations qui ont marqué l’histoire du monde depuis l’entrée dans l’ère industrielle au XVIIIe siècle, les économistes ont remarqué que le développement a semblé s’effectuer selon des grands cycles d’une durée de l’ordre de 50 à 60 ans : les grands cycles de Kondratiev (1892-1930, économiste soviétique). Ils sont illustrés par la figure suivante.

Les points A, B, C, D, E, etc., qui marquent par convention le début et la fin des grands cycles sont voisins de périodes de grandes crises économiques qui les précèdent d’une quinzaine d’années environ. On voit que la durée des grands cycles, successivement 50, 56 et 59 ans, présente une légère tendance à l’augmentation (mais les dates étant conventionnelles et approximatives – différents auteurs prenant souvent des dates différentes –, la tendance ainsi esquissée a-t-elle une quelconque signification ?). C’est pour prendre en compte toutes ces interrogations que nous avons arbitrairement fixé une durée de 60 ans pour le 4ème cycle qui, si notre hypothèse est bonne, devrait alors avoir de bonnes chances de se terminer vers le début du troisième millénaire.

A partir de ces points qui sont situés en général après une grande crise économique, prend naissance une phase de croissance très forte qui tend ensuite à plafonner et qui est suivie à son tour par une phase de déclin économique. Cette dernière se termine ensuite par une nouvelle phase de crise économique. De plus, les crises économiques se conjuguent en général avec d’autres événements sociaux et politiques de grande ampleur : le début conventionnel de l’ère industrielle à la fin du XVIIIe siècle et la crise qui l’accompagne (famines, inflation) *

|

* Cette "première" crise

doit en toute rigueur plutôt être regardée comme une crise agricole que

comme une crise véritablement industrielle dans la mesure où l'économie

mondiale était à cette époque de type essentiellement

agricole. |

avec la Révolution française ; la crise de 1815 avec la fin du monde napoléonien (traité de Versailles) et la redistribution des cartes en Europe ; la crise de 1870 (défaite française à Sedan) avec la conférence de Berlin (1884-1885) et le partage de l’Afrique entre les colonisateurs européens ; la crise de 1929-1930 avec le nazisme et la 2nde guerre mondiale ; la crise actuelle avec l’effondrement des régimes communistes totalitaires, la victoire de l’économie libérale de marché (victoire temporaire sans doute car rien ne semble jamais définitif dans l’histoire économique, sociale et politique) ainsi que l’état de guerre économique dans lequel nous nous trouvons.

Nous ne discuterons pas des considérations et des méthodes qui ont amené les économistes à fixer les dates de début et de fin des grands cycles. *

|

* Nous renvoyons le

lecteur vers des ouvrages plus spécialisés. Pour une approche assez

générale, on pourra se reporter au livre de P. FLICHY, L'innovation

technique, éditions La Découverte, Paris, 1995. |

Il faut aussi avoir à l’esprit que les dates ne sont qu’indicatives et ne doivent pas être prises avec trop de rigueur. Il est intéressant de remarquer que si ce modèle est prolongeable dans l’avenir, *

|

* Nous n'en savons bien

sûr strictement rien. Certains économistes (par exemple, Steven Weber de

l'université de Californie) pensent même qu'il pourrait très bien ne plus

y en avoir. Cependant, nous préférons l'hypothèse inverse selon laquelle

d'autres cycles vont se produire car c'est un moyen d'échapper au syndrome

de "fin de la physique". Une telle posture nous paraît aussi plus

constructive - et moins désespérante - que l'autre. |

nous nous situerions aujourd’hui au voisinage du point E, quelque part entre 1995 (dans l’hypothèse d’un cycle de 50 ans) et 2005 (dans l’hypothèse d’un cycle de 60 ans), c’est-à-dire au début du 5ème cycle de Kondratiev, encore plus ou moins empêtrés au plus profond d’une crise économique majeure. On remarquera une tendance à l’allongement de la durée des cycles. Est-elle significative ? Traduit-elle une augmentation de la "viscosité sociale" – comme diraient les sociologues – avec le temps, au fur et à mesure que le fonctionnement de la société se complexifie ? Bien évidemment nous ne trancherons pas. La période la plus noire de la crise actuelle se situerait de toute façon entre 1995 et 2005. Il se pourrait même que le point le plus bas ait donc déjà été dépassé ce qui devrait rendre particulièrement passionnante la période que nous nous apprêtons à vivre. *

|

* Au début de l’année

2000, l'ensemble des indicateurs économiques (taux de chômage) étaient au

beau fixe. Tout le monde ne parlait plus que de la "nouvelle économie". La

fameuse "reprise" était-elle enfin là ? Entrions-nous vraiment dans

le 5ème cycle de Kondratiev ? En fait, au moment où je

réfléchissais ainsi (juillet 2000), la bulle Internet commençait déjà à se

dégonfler et, depuis, sa débâcle a entraîné (à la date de fin 2002)

l'"évaporation" en bourse de 8000 milliards de $ ! Comme quoi, il ne

faut jamais vendre la peau de l'ours trop tôt... |

On observe également que les phases de croissance ont tendance à s’allonger (1792-1815, 1850-1873, 1896-1920, 1945-1975 ; cette dernière période correspond aux fameuses Trente Glorieuses) et que les phases de récession ont tendance à se raccourcir (1815-1850, 1873-1896, 1920-1940). Mais encore une fois, il faut être très prudent et se garder de vouloir extrapoler.

Il est également intéressant de noter qu’un historien, G. MENSCH, a identifié dans ce processus des périodes où l’innovation semble passer par des maxima : 1825, 1886, 1935. Il est frappant de constater que ces dates sont très voisines des périodes de fortes crises. Plus précisément, l'apogée de l'innovation est postérieure de quelques années aux grandes crises économiques. L’explication serait que l’augmentation du chômage et la sous-utilisation des capitaux qui se produisent dans ces périodes-là font diminuer l'hostilité et la méfiance vis-à-vis d'idées nouvelles qui n'ont jamais été essayées ; et si elles n’ont jamais été essayées dans des conditions économiques normales c’est justement parce qu’elles comportaient trop de risques. *

|

* Cf. P. FLICHY,

L'innovation technique, op. cit., p.175. |

Autrement dit, ce sont les situations de crise qui favoriseraient la prise de risques. Attitudes normales d’individus ou d’organisations plus ou moins fortement menacés et qui, conscients de cette menace, tentent en quelque sorte le tout pour le tout, dans des manœuvres que l’on pourrait qualifier de désespérées, afin d’essayer de s’en sortir. Autre paradoxe et en quelque sorte corollaire de ce qui précède : c’est dans les périodes où l’économie marche à un régime soutenu que l’on observe les minima d’innovation. Ainsi, l’une des périodes de tels minima correspond aux années 1953-1973 c’est-à-dire en plein dans ce que l’on a appelé les Trente Glorieuses !

Quels sont les domaines où les progrès techniques devraient se produire ? Là se situe indubitablement la grande question. Il est indéniable qu’un observateur vivant aux points A, B, C, D, E, etc. est difficilement en mesure de voir quelles vont être les technologies qui vont servir au développement du grand cycle suivant ; par exemple, qui aurait pu, vers 1886, prévoir l’importance des rôles qu’allaient jouer l’automobile, la radio-télévision (la TSF, comme on allait dire au début du siècle suivant), l’avion, la radioactivité, la pénicilline et les autres antibiotiques, au cours des deux grands cycles suivants ? Pour un tel observateur, un monde tout électrique – notre monde actuel (du moins dans les pays dits développés) – était tout à fait impensable (au sens étymologique : il ne pouvait pas être pensé). *

|

* Sauf pour quelques

visionnaires, penseurs et poètes tels que Jules Verne par

exemple. |

Si l’hypothèse que nous avons faite est bonne, à savoir que nous sommes près du début du prochain grand cycle économique, force est de constater que nous sommes face à la période 2000-2050 dans la même position que l’observateur de 1886 face à la période 1886-1945 (et a fortiori face à la période d’après, 1945-2000) : dans l’obscurité la plus complète.

Pourtant, beaucoup de spécialistes de prospective essaient depuis un certain temps de percer les secrets technologiques du futur et de prévoir de quoi notre vie sera faite demain. C’est ainsi qu’en cette fin de XXe siècle, on parle beaucoup des technologies de l’information et on ne saurait minimiser leur importance pour l’avenir. Cependant, il convient également de ne pas surestimer le rôle d’entraînement qu’elles pourront avoir sur l’ensemble des autres activités humaines et, au risque de choquer, nous faisons l’hypothèse que les progrès – ou plutôt les révolutions – technologiques se produiront ailleurs *.

|

* Ces lignes – qui

traduisent mon profond scepticisme envers la capacité des NTIC (Nouvelles

Technologies de l'Information et de la Communication) à nous faire sortir

de la crise en cristallisant autour d'elles la nouvelle révolution

technologique – ont été écrites au milieu des années 90 c'est-à-dire bien

avant "l'explosion de la bulle" de la "nouvelle économie" (celle autour de

l'Internet) à partir d'avril 2000, au moment où les experts prévoyaient

une croissance annuelle de 25 % des profits de ce secteur pour les 5

prochaines années ! Comme quoi la prospective est vraiment un art

difficile. |

Les technologies de l’information ne feront qu’accompagner – en les accélérant, en les facilitant ou même en rendant possibles certaines d’entre elles – les véritables révolutions ; de même un certain nombre de nouvelles techniques comme la robotique et l’automatisation, l’informatique et l’intelligence artificielle ainsi que ce que l’on nomme collectivement les biotechnologies. Nombre d’observateurs concluent que, d’ici à une dizaine d’années, 50 % des produits industriels consommés seront nouveaux. Ainsi, Cor Van der Klugt, P.D.G. du groupe Philips, n’hésitait-il pas à déclarer, en mai 1986 : "dans cinq ou sept ans, la moitié des produits électroniques grand public vendus le seront à partir de produits qui n’existent pas aujourd’hui. Ce n’est plus une course, c’est un marathon".

Mais les véritables révolutions se préparent encore ailleurs, probablement en liaison avec les domaines précédents, mais en d’autres lieux ; ces révolutions contribueront sans doute à changer de façon phénoménale nos manières de travailler, de communiquer, de consommer, de vivre, d’échanger avec les autres et on peut penser qu’elles impliqueront nécessairement un ou plusieurs des secteurs basiques suivants :

- soins, santé, médecine et médicaments ;

- alimentation, nutrition et agro-alimentaire ;

- énergie, matériaux et transports.

Quels sont les indices dont nous pouvons disposer actuellement et sur lesquels nous pouvons nous appuyer pour essayer de faire de la prospective ?

Pour le premier domaine, la réussite d’une opération de clonage d’une brebis à partir d’une simple cellule de brebis adulte (et celle du clonage de deux singes) en 1997 nous donnent la pleine mesure de ce qui est scientifiquement et techniquement possible de faire dès aujourd’hui. Les problèmes éthiques soulevés sont cependant considérables et rien ne permet de dire quelles lignes à ne pas franchir devront être mises en place et si elles le seront ; et, dans ce cas, si elles seront effectivement respectées par tous. *

|

* On semble se heurter là

à une sorte de principe intangible relatif à l'innovation : dès qu'une

découverte est faite il se trouve immédiatement quelqu'un qui va vouloir

l'utiliser. Ainsi, pour ne citer que des exemples récents, les premières

utilisations en plein champ de souches végétales transgéniques n'ont pas

attendu une autorisation officielle et ont été réalisées sans aucun

contrôle des autorités politiques ou académiques ; de même pour le premier

cas d'application d'une thérapie génique à un être humain. |

Dans ce même domaine, à signaler également les activités de la société américaine HGS (Human Genome Sciences) créée par William Haseltine, ex-professeur à Harvard. Cette entreprise entend développer un nouveau type de médecine dite de réparation ou de restauration. Si elle arrive à voir le jour, cette nouvelle médecine appelée régénératrice s’appuiera sur la capacité qu’auraient les gènes à restaurer plus ou moins spontanément la fonctionnalité de tel ou tel organe.

Pour le deuxième domaine, la production toujours plus facile d’êtres vivants (végétaux et animaux) transgéniques dotés "à la carte" de propriétés modifiées (et jugées souhaitables notamment pour des raisons économiques liées au marché) va poser le même type de questions que ci-dessus : a-t-on fait en particulier le tour des conséquences sanitaires, épidémiologiques, environnementales possibles de l’utilisation industrielle de ces nouvelles techniques ? et qu’est-ce qui est moralement acceptable ?

Pour le troisième domaine, le point d’interrogation essentiel réside dans la place qui sera tenue par le nucléaire compte tenu des problèmes politiques (acceptation ou rejet par les populations), géostratégiques (non dissémination des armes) ou sanitaires (à court terme : risques acceptables en matière de santé publique ; à long terme : risques génétiques). Quant aux axes le long desquels le progrès technique va se faire, on peut en dessiner plusieurs :

- supraconduction aux hautes températures : en rendant accessibles les champs magnétiques très intenses, possibilité de créer des moteurs électriques à performances inégalables ; mais surtout possibilité, avec la MHD (magnétohydrodynamique), de disposer d’un mode de propulsion qui pourrait devenir révolutionnaire ; *

|

* Les Japonais ont réussi

à propulser un prototype de navire de surface uniquement par l'action de

champs électriques et magnétiques. Cf. les actes de MHDS 91 (International

Symposium on Superconducting Magnetohydrodynamic Ship Propulsion), 28-31

octobre 1991, Kobe, Japon. Mais les conditions utilisées sont

aujourd'hui économiquement non rentables car on ne sait pas

réaliser des champs magnétiques suffisamment intenses à un coût acceptable

; du moins, ceci est la version officielle. Des informations officieuses

laissent à penser que les militaires américains pourraient en savoir

beaucoup plus que ce qui est généralement admis... |

- nanotechnologies

et micromécanique : miniaturisation extrême de tous les dispositifs mécaniques

et électromécaniques, y compris les moteurs et actionneurs (d’où l’explosion

prévisible des automates et des robots) ; mais aussi possibilité de "voir"

les atomes et de les manipuler un par un ;

- fusion

nucléaire froide : domaine pour l’instant très controversé – pour ne

pas dire plus ! – dans la mesure où la communauté scientifique mondiale est

divisée en deux tendances opposées (ceux qui "y croient" étant très largement

minoritaires – mais souvenons-nous de la "fin de la physique"). Les perspectives

offertes par la fusion froide, si elles se confirment, sont proprement vertigineuses.

*

|

*

Cf.

N. HOFFMAN, A Dialogue on Chemically Induced Nuclear Effects, A Guide

for the Perplexed About Cold Fusion, American Nuclear Society, La

Grange Park, Illinois, 1995. L'auteur est ingénieur

métallurgiste et travaille chez Rocketdyne (simultanément division de

Rockwell International et laboratoire du Department of Energy

américain). |

[À signaler qu’il se tient, chaque année ou presque, une conférence internationale sur la fusion froide. La 11ème, intitulée ICCF 11,a eu lieu à Marseille du 31 octobre au 5 novembre 2004. Les curieux et autres sceptiques sont encouragés à remettre leurs pendules à l’heure. Accès au site].

Il se pourrait aussi que toutes les pistes évoquées précédemment ne soient que roupie de sansonnet. Dans ce cas, le changement de paradigme qui est en train de se profiler pourrait être encore plus révolutionnaire que tout ce que nous pouvons imaginer. Et si notre modèle du monde physique n’était tout bonnement pas "complètement à côté de la plaque" ? Mais, comme le présent chapitre se voulait sérieux, je ne franchirai pas la ligne blanche, me contentant de renvoyer le lecteur vers un texte extrêmement roboratif signé de Philippe Viola : Les Saines Écritures. Si une véritable révolution ne finit pas par déboulonner les mandarins actuels qui règnent sans partage (pas très grave) sur l’orthodoxie scientifique et qui empêchent tout nouveau bond qualitatif (beaucoup plus embêtant) dans le domaine des idées, ce n’est pas avant plusieurs générations que nous pourrons enfin sortir du marasme dans lequel la science actuelle est empêtrée.

Un simple exemple de "choses" qui étaient imprévues et qui, si elles sont avérées, pourraient être porteuses de révolution(s) scientifique(s). On se souvient que le programme ITER vise à obtenir et contrôler, au sein d'une enceinte torique (un Tokamak), des températures de l'ordre de 100 à 150 millions de degrés. Or, en 2006, les laboratoires Sandia (au Nouveau Mexique), organe de recherche américain travaillant sous contrat avec la défense des États-Unis, font savoir au monde entier qu'ils viennent d'obtenir une température de 2 milliards de degrés (depuis, on est passé à 3 milliards !) au cours d'une expérience de physique qui n'a rien à voir avec la configuration Tokamak.

[Pour aller plus loin, voir par exemple cet article scientifique : Ion Viscous

Heating in a Magnetohydrodynamically Unstable Z Pinch at Over 2 X 10^9 Kelvin,

M.G. Haines, P.D. LePell, C.A. Coverdale, B. Jones, C. Deeney and J.P. Apruzese,

Physical Review Letters, 96, 0075003 (2006). Pour les non scientifiques, commencer

par ces quelques pages Internet :

http://www.futura-sciences.com/fr/sinformer/actualites/news/t/physique-1/d/la-z-machine-depasse-les-deux-milliards-de-degres_8419/

http://www.sandia.gov/news/resources/releases/2007/rapid-fire-pulse.html

http://www.lesechos.fr/info/metiers/4576329.htm

]

Le montage expérimental des Américains porte le nom de "Z

Machine" (car on y crée ce que l'on appelle un "Z pinch"

c'est-à-dire un pincement d'un champ magnétique autour de l'axe

des "z" sous l'effet des forces de Laplace prenant naissance dans

un plasma parcouru par un très fort courant électrique). Ayant

été l'un des premiers en France a avoir eu l'information, je me

suis empressé à l'époque de la transmettre, pour avis,

à l'un de mes laboratoires très impliqué dans ITER. Que

croyez-vous qu'il advînt ? Rien du tout, évidemmment ; pas même

un accusé de réception ! Sans doute en accord avec ce vieux principe

: "cachez cette température que je ne saurais voir... car, évidemment,

c'est impossible".

Le lecteur aura compris que je ne porte pas de jugement moral sur cette affaire...

à suivre. Donc : wait and see.

10. QUELLE PLACE POUR L’HOMME ?

Il semble que la science du XXe siècle est entrée en révolution, confrontée à l’émergence du désordre, de l’incertain et du complexe qui rendent caduques nos vieux instruments de pensée. Une meilleure connaissance du monde inclut une meilleure connaissance de l’homme, de la société et de leur fonctionnement. Pour que les progrès de la science soient réellement au service de l’homme, il faut nécessairement améliorer notre connaissance des autres, ce qui englobe les deux modes de connaître autrui : expliquer (c’est la connaissance de l’objet en tant qu’objet), et comprendre (c’est la connaissance de sujet à sujet). Il n’y aura pas de véritable progrès, de progrès complet, sans une véritable implication des sciences humaines et sociales.

Si le mot de la fin devait être laissé aux sciences humaines et sociales, nous devrions méditer cette pensée d’Edgar Morin : "Oui, nous avons besoin de connaissance scientifique. Mais faute de comprendre autrui, nous resterons des barbares." *

|

* E. MORIN, conclusion

des 6èmes Rencontres Sciences & Citoyens, 1-3/11/96, Lyon.

Cité dans Le Journal du CNRS, n°84, décembre 1996,

p.26. |

Devant la complexité du monde, dit encore Morin, le scientifique a un impérieux devoir d’incertitude : les contradictions ne demandent plus à être éliminées ou dépassées, elles doivent être acceptées, car elles font partie du réel, qu'elles "tissent ensemble" (complexus). *

|

* E. MORIN, Mes

démons, édit. Stock. Voir aussi du même auteur :

Autocritique ; La Méthode ; La Complexité humaine

;Les Sept Savoirs nécessaires à l'éducation du futur, édit. du Seuil,

2000. |